Mostrar los tags: mi

Mostrando del 11 al 20 de 264 coincidencias

Se ha buscado por el tag: mi

El ejercicio se configura y ejecuta con parámetros mínimos con el fin de

que las salidas impresas por consola no sean grandes. Se puede jugar con estos

valores:

np.random.seed(0)

X = 2 * np.random.rand(20, 1)

y = 4 + 3 * X + np.random.randn(20, 1)

learning_rate = 0.1

batch_size = 10

epochs = 10

***************************************************************************************************************

El descenso de gradiente Mini-Batch es una técnica de optimización ampliamente utilizada en el aprendizaje automático y la optimización numérica. Permite entrenar modelos de manera eficiente al actualizar los pesos del modelo en función de un subconjunto (mini-lote o mini-batch) de datos de entrenamiento en lugar de utilizar el conjunto de datos completo en cada iteración. Además, en algunos casos, se introducen elementos de aleatoriedad en la selección de estos mini-lotes para mejorar la convergencia y evitar que el algoritmo quede atrapado en mínimos locales.

Aquí hay un resumen de cómo funciona el descenso de gradiente Mini-Batch con entrada de datos aleatorios:

División del conjunto de datos: En lugar de usar todo el conjunto de datos de entrenamiento en cada iteración (como se hace en el descenso de gradiente por lotes), el conjunto de datos se divide en mini-lotes más pequeños. La elección del tamaño del mini-lote es un hiperparámetro importante que debe ajustarse según las características de los datos y el modelo.

Aleatorización de los datos: Para introducir aleatoriedad, el conjunto de datos se suele barajar (mezclar) al comienzo de cada época (una época se completa después de que el modelo haya visto todos los mini-lotes). Esto evita que el modelo se ajuste a patrones específicos del orden en que se presentan los datos y mejora la generalización.

Iteración: El algoritmo recorre las épocas, y en cada época, se selecciona un mini-lote aleatorio de datos. Los pesos del modelo se actualizan en función del gradiente calculado utilizando solo los ejemplos en ese mini-lote. La actualización de los pesos se realiza de acuerdo con la dirección del gradiente descendente, como en el descenso de gradiente estándar.

Convergencia: El proceso se repite durante varias épocas hasta que el algoritmo alcance un criterio de convergencia predefinido (por ejemplo, una pérdida baja o un número máximo de épocas).

La aleatorización de los mini-lotes y la aleatorización de los datos en cada época ayudan a evitar que el descenso de gradiente Mini-Batch quede atrapado en mínimos locales y mejora la capacidad del algoritmo para generalizar a nuevos datos. También hace que el entrenamiento sea más eficiente en términos de tiempo y memoria en comparación con el descenso de gradiente por lotes.

El descenso de gradiente Mini-Batch es especialmente útil cuando se trabaja con grandes conjuntos de datos que no caben en la memoria, ya que permite entrenar modelos de manera más rápida y escalable utilizando recursos computacionales limitados.Descenso de gradiente Mini Batch.

********************************

MiniBatch-Aula_228-B.py

******************************************************************************************

El descenso de gradiente mini batch, también conocido como Mini Batch Gradient Descent, es una variante del algoritmo de optimización del descenso de gradiente utilizado en el aprendizaje automático y la optimización de modelos de redes neuronales. A diferencia del descenso de gradiente estocástico (SGD) y el descenso de gradiente por lotes (Batch Gradient Descent), el descenso de gradiente mini batch combina características de ambos enfoques.

En el descenso de gradiente mini batch, los datos de entrenamiento se dividen en lotes más pequeños, cada uno de los cuales se utiliza para calcular una actualización parcial de los pesos del modelo. Estos lotes más pequeños se llaman "mini lotes". La idea detrás de esta técnica es encontrar un equilibrio entre la eficiencia de la actualización de parámetros y la variabilidad de las actualizaciones en comparación con el SGD y el Batch Gradient Descent.

Aquí hay una descripción paso a paso del proceso del descenso de gradiente mini batch:

División de los datos: Los datos de entrenamiento se dividen en mini lotes de tamaño fijo. El tamaño del mini lote es un hiperparámetro que se puede ajustar según las necesidades del problema. Por lo general, los tamaños de mini lotes varían desde 16 hasta 256 ejemplos, pero esto puede variar según el conjunto de datos y la arquitectura de la red.

Inicialización de pesos: Se inicializan los pesos del modelo de manera aleatoria o utilizando algún método de inicialización específico.

Cálculo del gradiente: Para cada mini lote, se calcula el gradiente de la función de pérdida con respecto a los pesos del modelo utilizando solo los ejemplos en ese mini lote. Esto se hace utilizando retropropagación (backpropagation).

Actualización de pesos: Los pesos del modelo se actualizan utilizando el gradiente calculado. La fórmula de actualización es similar a la del descenso de gradiente estocástico, pero en lugar de utilizar un solo ejemplo, se promedian los gradientes de todos los ejemplos en el mini lote. Esto suaviza las actualizaciones y reduce la variabilidad en comparación con el SGD.

Iteración: Se repiten los pasos 3 y 4 para cada mini lote. Este proceso se repite a lo largo de múltiples épocas hasta que se alcance un criterio de parada, como un número máximo de épocas o una convergencia satisfactoria.

Ventajas del descenso de gradiente mini batch:

Mayor eficiencia computacional en comparación con el Batch Gradient Descent, ya que se aprovecha el paralelismo en las operaciones matriciales.

Menor variabilidad en las actualizaciones de peso en comparación con el SGD, lo que puede llevar a una convergencia más rápida y estable.

El descenso de gradiente mini batch es una elección común para entrenar modelos de redes neuronales en la práctica, ya que combina las ventajas de SGD y Batch Gradient Descent. El tamaño del mini lote es un hiperparámetro crítico que debe ajustarse según el problema y la memoria disponible.

La aplicación de Bienestar y Autocuidado es una herramienta completa diseñada para ayudar a las personas a cuidar su bienestar físico y mental. Con esta aplicación, los usuarios pueden acceder a una variedad de funciones y características que les permiten mejorar su calidad de vida y mantener un equilibrio saludable.

La aplicación ofrece un seguimiento de actividades físicas, lo que permite a los usuarios registrar y monitorear sus entrenamientos, ya sea correr, caminar, hacer yoga u otras actividades. También incluye una biblioteca de meditaciones guiadas, con opciones para diferentes propósitos, como relajación, concentración y reducción del estrés. Los usuarios pueden elegir entre una variedad de meditaciones y establecer recordatorios para practicarlas regularmente.

Además, la aplicación proporciona recordatorios para beber agua y realizar estiramientos, ayudando a los usuarios a mantenerse hidratados y evitar la rigidez muscular. También ofrece consejos de nutrición y sugerencias para llevar una alimentación saludable, lo que permite a los usuarios tomar decisiones informadas sobre su dieta.

Una función destacada de la aplicación es el diario personal, donde los usuarios pueden registrar sus pensamientos, emociones y experiencias diarias. Esto les brinda la oportunidad de reflexionar, expresarse y llevar un seguimiento de su bienestar mental. También pueden establecer metas personales y realizar un seguimiento de su progreso a lo largo del tiempo.

En resumen, la aplicación de Bienestar y Autocuidado es una herramienta completa que brinda a los usuarios la capacidad de cuidar su bienestar físico y mental de manera integral. Con características como el seguimiento de actividades físicas, meditaciones guiadas, recordatorios, consejos de nutrición y un diario personal, la aplicación fomenta el autocuidado y ayuda a los usuarios a llevar una vida equilibrada y saludable.

Dada dos fechas diferentes; en formato DateTime, esta función devuelve el tiempo transcurrido entre ambas en una sola cadena de texto. Indicando, años, meses, semanas, días, horas, minutos y segundos.

Observa que se toma en cuenta el singular del plural en las cantidades mayores a 1.

Saludos y comenten!

Es una aplicación de línea de comandos, a la que puedes pasar un color, y la aplicación transforma las imágenes de entrada a una imagen en escala de ese color (como si fuera una escala de grises, pero en lugar de gris, ese color).

Además, se puede asignar el valor global del alpha de la imagen, y también traducir un color concreto para que sea totalmente transparente (alpha = 0).

Se puede desactivar el componente alpha, por si la imagen de entrada es un .jpg, o por si hay alguna restricción que impide a la aplicación escribir con éxito la imagen transformada.

Si no conoces el código del color, puedes pasar un color: -color input y la aplicación te permitirá mover el ratón por la pantalla, y cuando pulses retorno de carro, se tomará el código del color sobre el que se encuentra el ratón.

(Esto no funciona correctamente en ciertos entornos, pero siempre podrás mover el ratón sobre tu color antes de lanzar la aplicación).

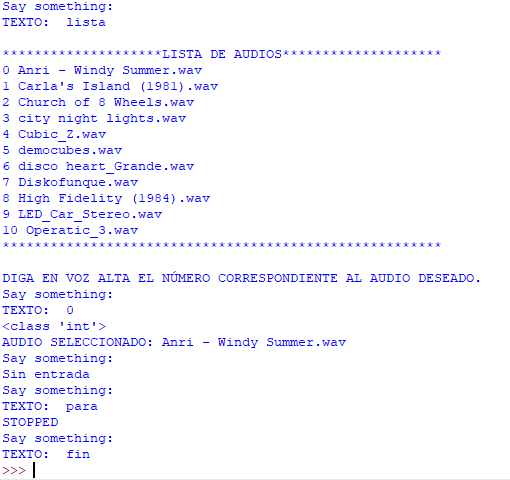

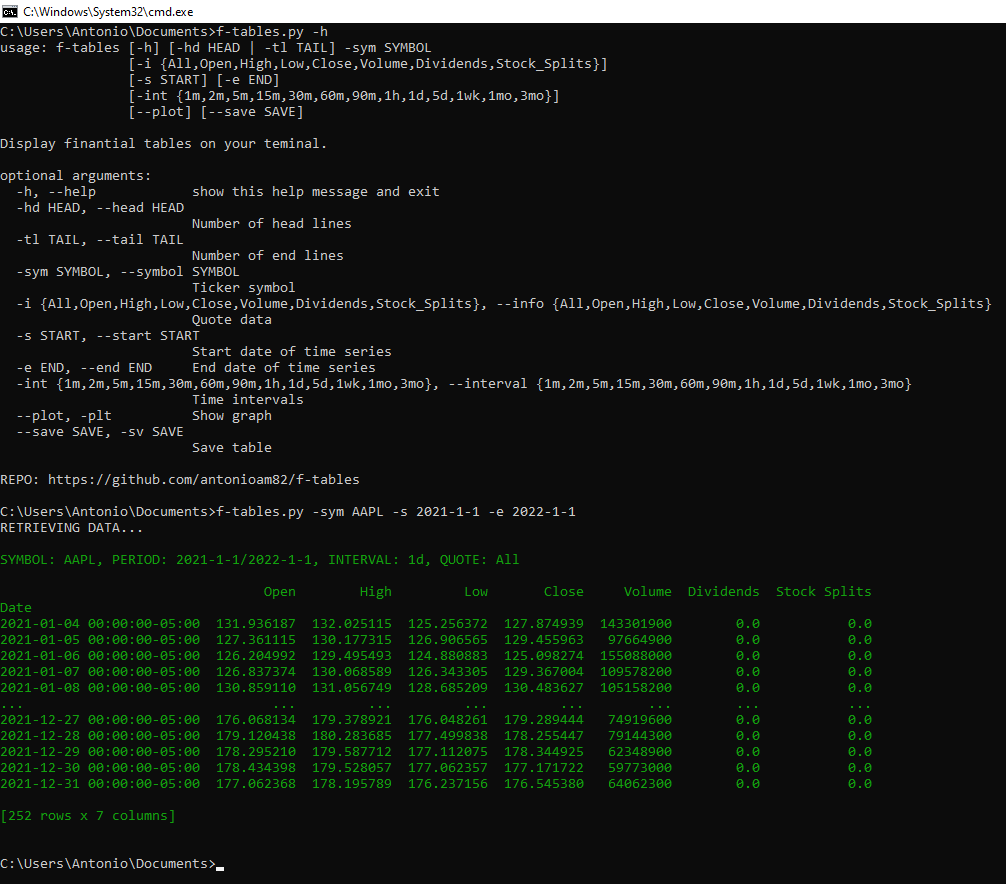

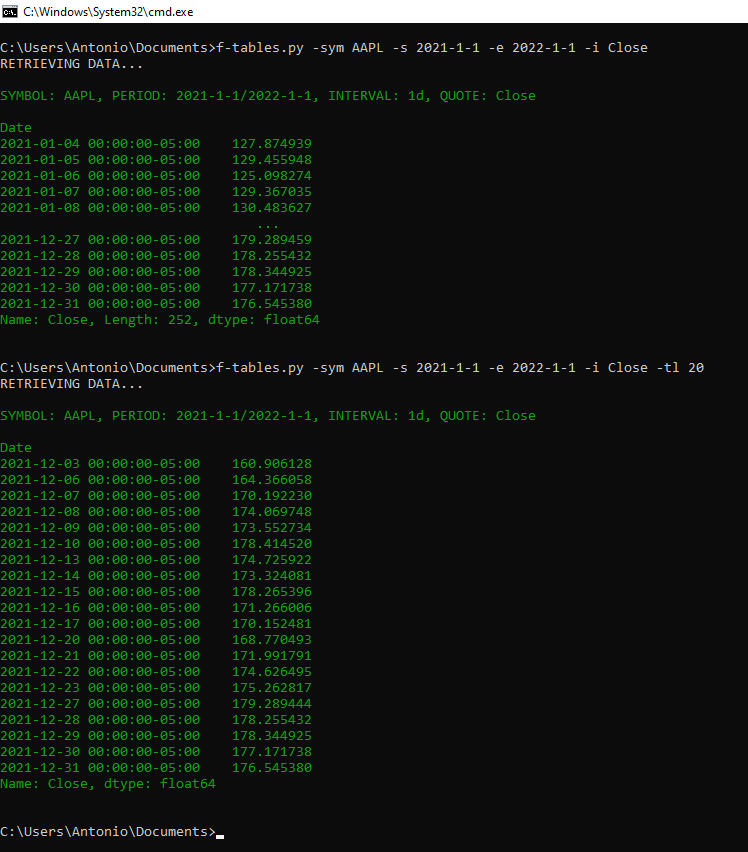

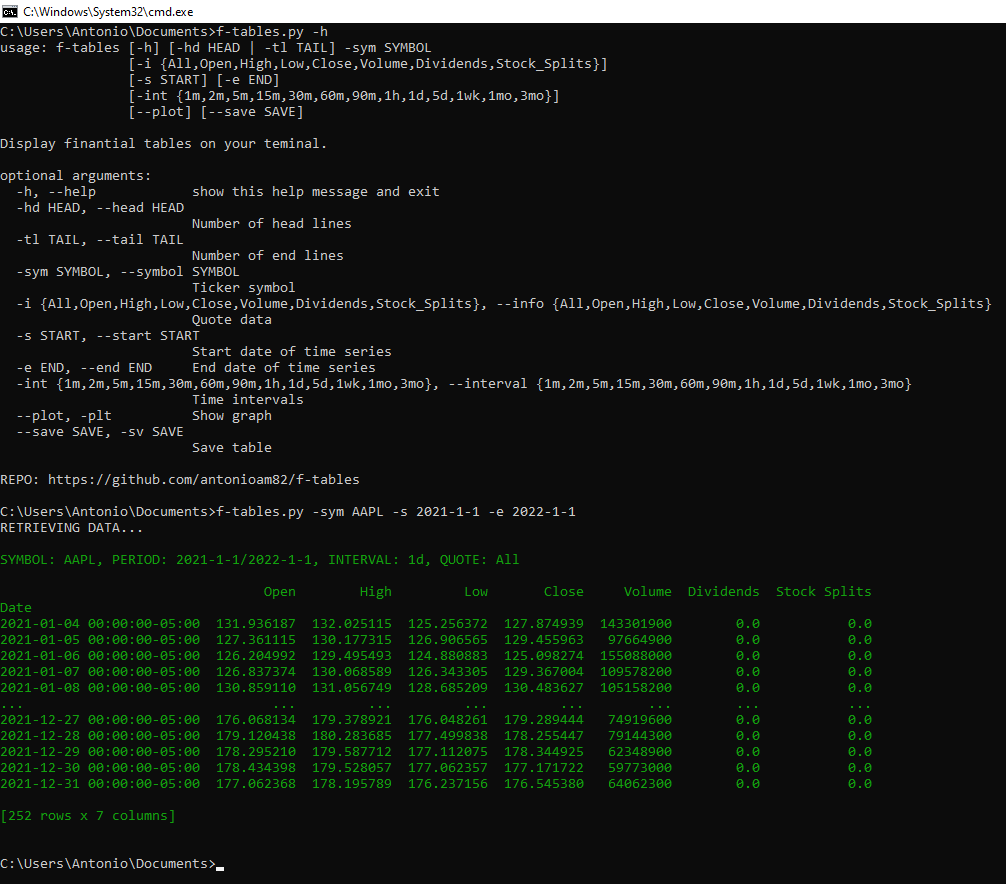

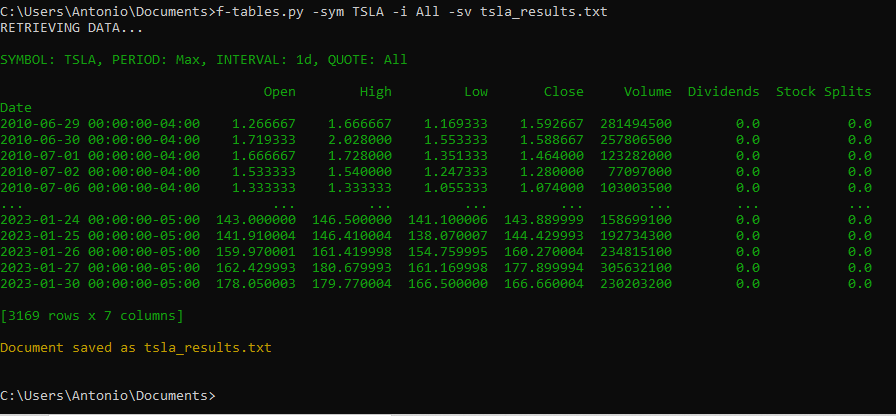

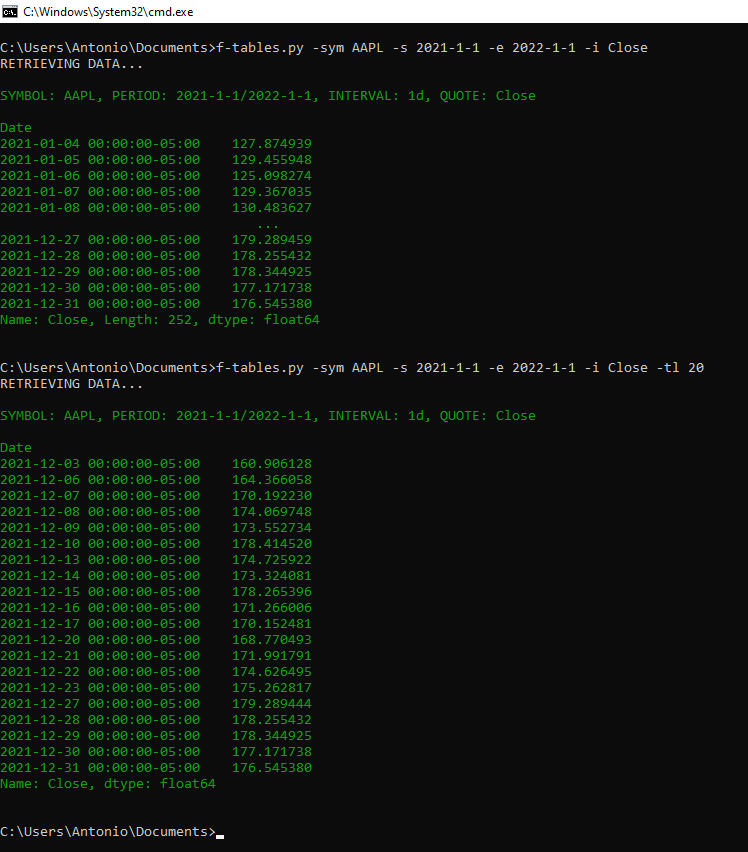

Este programa ('f-tables.py') muestra en formato tabla, los precios de acciones en el terminal, haciendo uso de la API de Yahoo Finance. Incluyendo la posibilidad de guardarlas en un documento de texto, así como mostrar gráficas.

ARGUMENTOS:

-sym/--symbol: Define el Ticker o simbolo de la empresa cuyos valores quiere conocerse (Obligatorio).

-i/--info: Información que se quiere obtener (Opcional).

-s/--start: Fecha de inicio de la serie histórica (Opcional).

-e/--end: Fecha final de la serie histórica (Opcional).

-int/--interval: Intervalos de tiempo en los que se muestran los datos (Opcional).

-sv/--save: Nombre del archivo de texto en el que se quiere guardar la tabla generada (Opcional).

-plt/--plot: Grafica precios de la tabla (Opcional).

-hd/--head: Número de filas iniciales a mostrar (Opcional).

-tl/--tail: Número de filas finales a mostrar (Opcional).

PARA CUALQUIER DUDA U OBSERVACIÓN, USEN LA SECCIÓN DE COMENTARIOS.

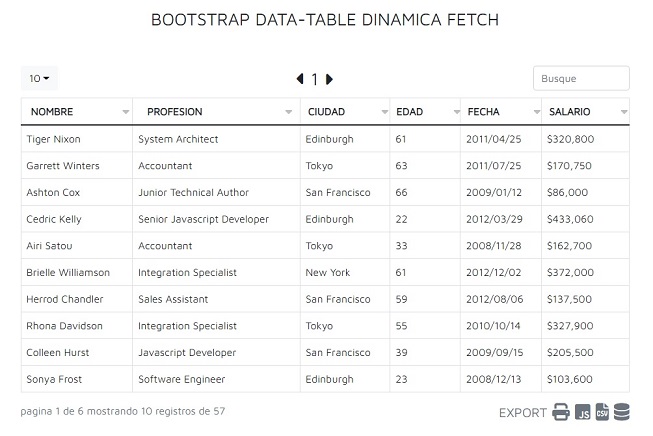

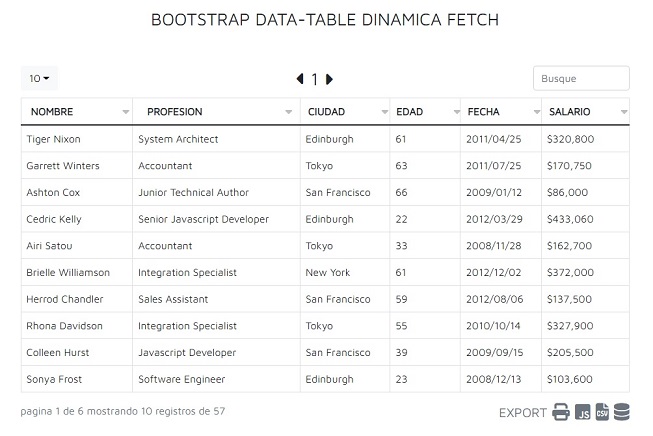

Suelo trabajar con Bootstrap y ya no queria usar JQuery para manejar la libreria DataTable.

Se que existen muchas librerias DataTable con Vanilla Javascript, Vue, React, etc..

Pero queria tener algo sencillo, de solo configurar 3-4 variables y armar mi datatable dinamica.

Pues bien como suelo usar Bootstrap me ahorre de hacer el css y solo me hice el js.

Lo publico por si alguien desea usarlo y/o se animan para crear un nucleo solido con funciones mas complejas.

Repito cualquier error por favor háganlo saber (que debo tener), ya que lo hice al paso y aun no lo uso en producción.

Realiza ordenamiento burbuja de un array con javascript

Permite ordenar los datos por medio de insercion.

Abriendo un espacio en un vector determinado para colocar el item

Por ejemplo en 2,3,4,1.

Abriria entre 2 y 4 para colocar el 1 y asi sucesivamente hasta que quede en: 1,2,3,4

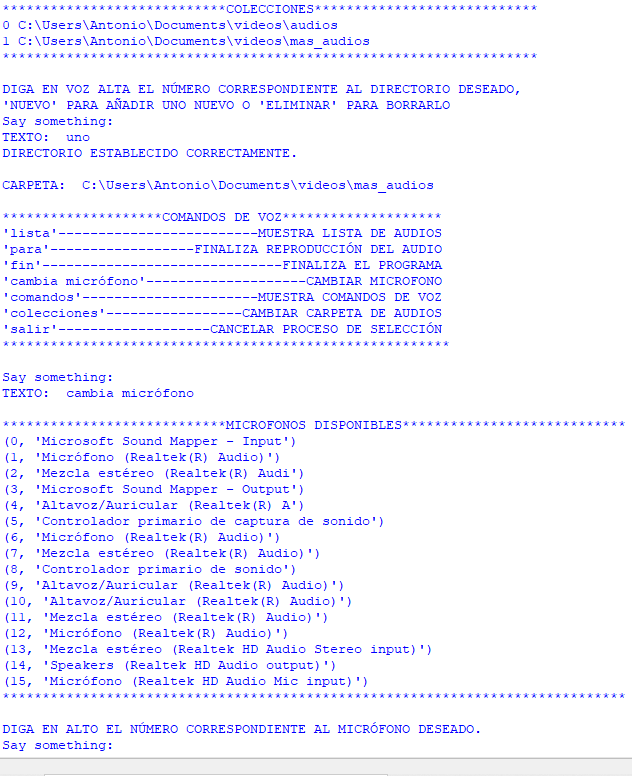

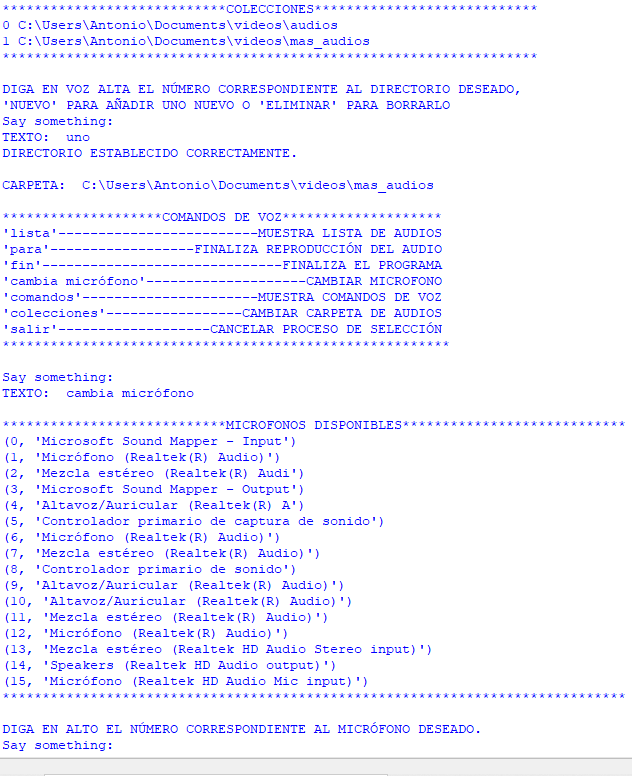

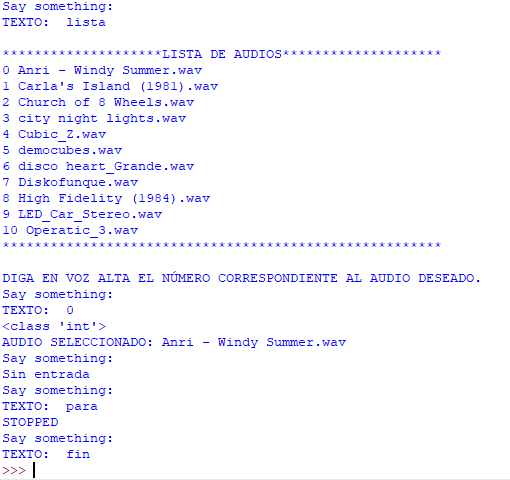

El presente código, permite al usuario, reproducir un archivo de audio (en formato ".wav"), escogiéndolo de una lista. A su vez, el programa se comunicará al usuario tanto a través de mensajes de texto como por mensajes de voz.

El programa se inicia, pidiendo el ingreso de la ruta al directorio en el que se encuentran los audios. Tras ello el usuario usará los comandos de voz para realizar las siguientes acciones:

COMANDOS PRINCIPALES:

"lista": Muestra la lista, numerada de archivos de audio, presentes en la carpeta indicada. Para reproducir uno de los archivos el usuario dirá en voz alta el número correspondiente al audio deseado (Este procedimiento también se seguirá para cambiar de micrófono).

"para": Finaliza la reproducción en curso de un audio.

"cambia micrófono": Despliega un listado con los micrófonos disponibles, para su selección numérica.

"comandos": Muestra la lista de comandos principales.

"fin": Finaliza la ejecución del programa.