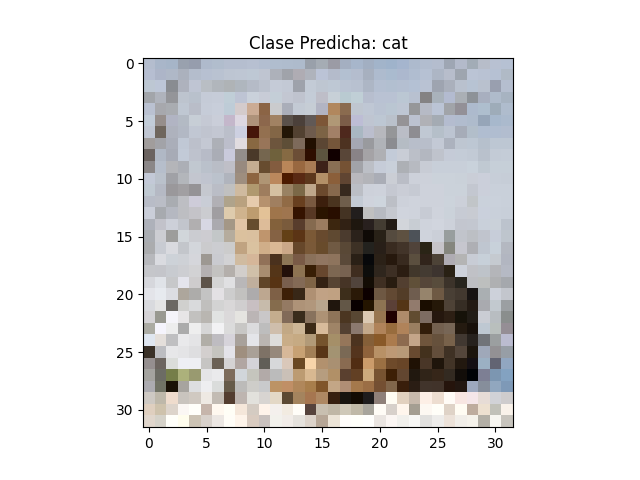

En el ejercicio:

106, en la línea de codigo referente a la compilacion del modelo:

model.compile(optimizer='rmsprop', loss='binary_crossentropy', metrics=['accuracy'])

aparece como paso a la función esta igualdad: optimizer='rmsprop'.

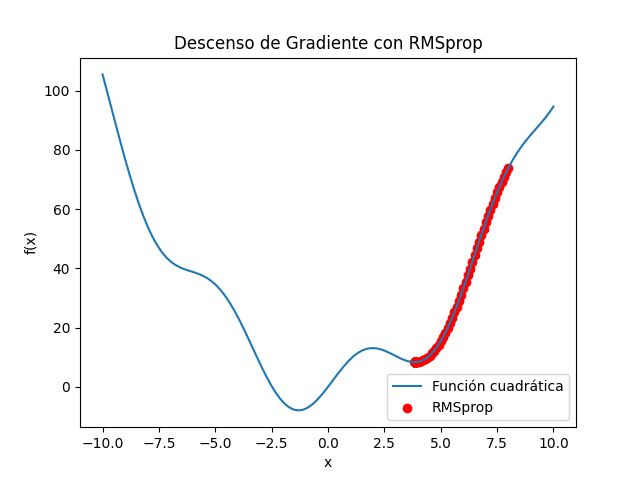

A continuación en el ejercicio: Aula-28_RMSprop.py, explicamos un poco este tipo de descenso de gradiente aplicado

para optimizar el modelo.

*********************************************************************************************************************

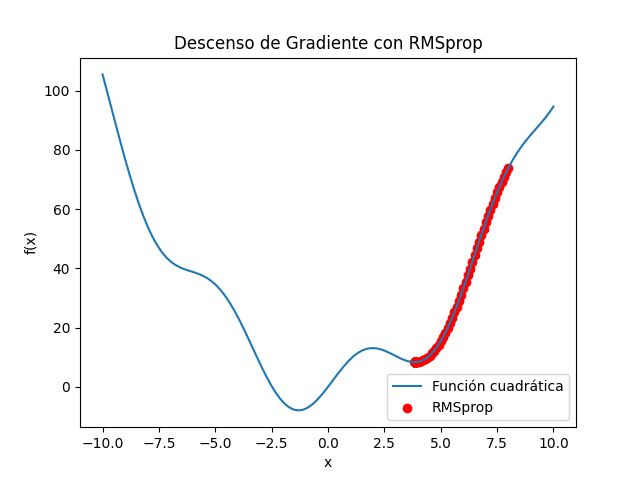

En el descenso de gradiente normal, la tasa de aprendizaje (cuánto nos movemos en la dirección opuesta al gradiente) es constante. Pero a veces, puede ser beneficioso ajustar esa tasa de aprendizaje.

RMSprop hace lo siguiente:

Miramos los gradientes pasados:

RMSprop lleva un registro de cuán grandes fueron los gradientes que hemos visto antes.

Adaptamos la tasa de aprendizaje:

Si los gradientes han sido grandes, RMSprop reduce la tasa de aprendizaje.

Si los gradientes han sido pequeños, RMSprop aumenta la tasa de aprendizaje.

Evitamos divisiones por cero:

RMSprop utiliza un pequeño número llamado

ϵ para evitar divisiones por cero.

En resumen:

RMSprop ajusta automáticamente la tasa de aprendizaje para cada parámetro en función de cómo fueron los gradientes anteriores.

Esto ayuda a converger más rápido en problemas donde las dimensiones de las características pueden variar mucho.

Imagina que estás en una montaña (la función de pérdida) y quieres bajar (minimizar la pérdida). RMSprop te ayuda a ajustar la rapidez con la que te mueves hacia abajo dependiendo de lo empinada que sea la pendiente. Si la pendiente es pronunciada, te mueves más despacio; si es suave, te mueves más rápido. ¡Es como ajustar el paso mientras caminas

hacia abajo para no caerte!

*****************************************************************************************

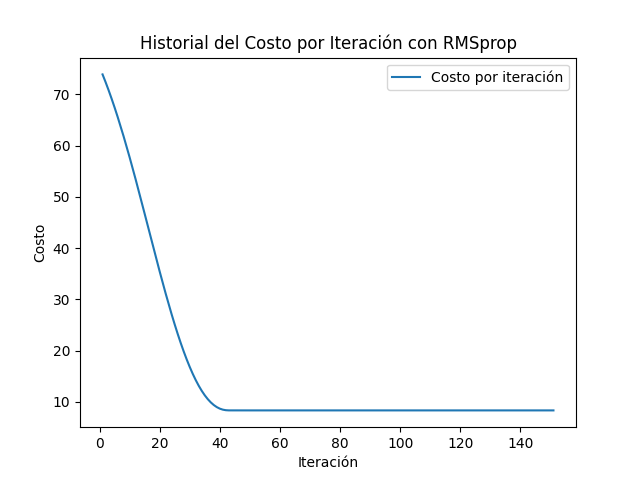

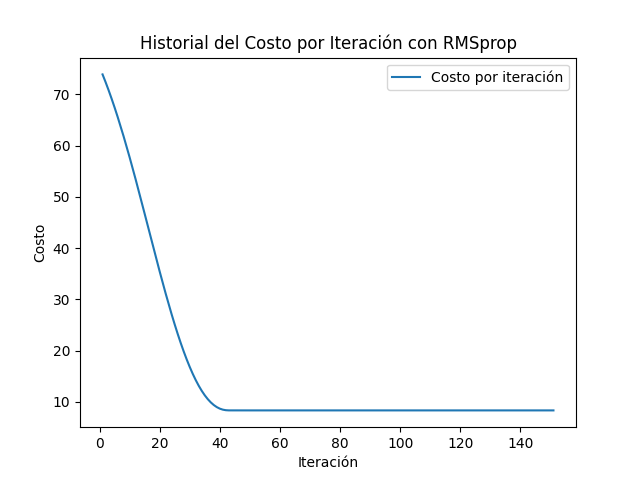

SALIDA RELACIÓN ITERACIÓN Y COSTO:

***************************************************

Paso 1: x = 8.0000, y = 73.8936, Costo = 73.8936

Paso 2: x = 7.9002, y = 72.4027, Costo = 72.4027

Paso 3: x = 7.8004, y = 70.8319, Costo = 70.8319

Paso 4: x = 7.7006, y = 69.1814, Costo = 69.1814

Paso 5: x = 7.6007, y = 67.4522, Costo = 67.4522

Paso 6: x = 7.5009, y = 65.6462, Costo = 65.6462

Paso 7: x = 7.4010, y = 63.7664, Costo = 63.7664

Paso 8: x = 7.3011, y = 61.8168, Costo = 61.8168

Paso 9: x = 7.2012, y = 59.8021, Costo = 59.8021

Paso 10: x = 7.1014, y = 57.7281, Costo = 57.7281

Paso 11: x = 7.0015, y = 55.6011, Costo = 55.6011

Paso 12: x = 6.9015, y = 53.4284, Costo = 53.4284

Paso 13: x = 6.8016, y = 51.2177, Costo = 51.2177

Paso 14: x = 6.7017, y = 48.9775, Costo = 48.9775

Paso 15: x = 6.6018, y = 46.7167, Costo = 46.7167

Paso 16: x = 6.5019, y = 44.4446, Costo = 44.4446

Paso 17: x = 6.4020, y = 42.1708, Costo = 42.1708

Paso 18: x = 6.3021, y = 39.9052, Costo = 39.9052

Paso 19: x = 6.2022, y = 37.6576, Costo = 37.6576

Paso 20: x = 6.1023, y = 35.4382, Costo = 35.4382

Paso 21: x = 6.0024, y = 33.2567, Costo = 33.2567

Paso 22: x = 5.9024, y = 31.1228, Costo = 31.1228

Paso 23: x = 5.8025, y = 29.0461, Costo = 29.0461

Paso 24: x = 5.7027, y = 27.0356, Costo = 27.0356

Paso 25: x = 5.6028, y = 25.0999, Costo = 25.0999

Paso 26: x = 5.5029, y = 23.2470, Costo = 23.2470

Paso 27: x = 5.4030, y = 21.4844, Costo = 21.4844

Paso 28: x = 5.3032, y = 19.8188, Costo = 19.8188

Paso 29: x = 5.2034, y = 18.2561, Costo = 18.2561

Paso 30: x = 5.1036, y = 16.8016, Costo = 16.8016

Paso 31: x = 5.0038, y = 15.4594, Costo = 15.4594

Paso 32: x = 4.9041, y = 14.2328, Costo = 14.2328

Paso 33: x = 4.8044, y = 13.1243, Costo = 13.1243

Paso 34: x = 4.7048, y = 12.1353, Costo = 12.1353

Paso 35: x = 4.6053, y = 11.2660, Costo = 11.2660

Paso 36: x = 4.5060, y = 10.5160, Costo = 10.5160

Paso 37: x = 4.4069, y = 9.8837, Costo = 9.8837

Paso 38: x = 4.3082, y = 9.3663, Costo = 9.3663

Paso 39: x = 4.2102, y = 8.9604, Costo = 8.9604

Paso 40: x = 4.1135, y = 8.6612, Costo = 8.6612

Paso 41: x = 4.0196, y = 8.4625, Costo = 8.4625

Paso 42: x = 3.9329, y = 8.3549, Costo = 8.3549

Paso 43: x = 3.8667, y = 8.3192, Costo = 8.3192

Paso 44: x = 3.8413, y = 8.3156, Costo = 8.3156

Paso 45: x = 3.8379, y = 8.3156, Costo = 8.3156

Paso 46: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 47: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 48: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 49: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 50: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 51: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 52: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 53: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 54: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 55: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 56: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 57: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 58: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 59: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 60: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 61: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 62: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 63: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 64: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 65: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 66: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 67: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 68: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 69: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 70: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 71: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 72: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 73: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 74: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 75: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 76: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 77: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 78: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 79: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 80: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 81: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 82: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 83: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 84: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 85: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 86: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 87: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 88: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 89: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 90: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 91: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 92: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 93: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 94: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 95: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 96: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 97: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 98: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 99: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 100: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 101: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 102: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 103: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 104: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 105: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 106: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 107: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 108: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 109: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 110: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 111: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 112: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 113: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 114: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 115: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 116: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 117: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 118: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 119: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 120: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 121: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 122: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 123: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 124: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 125: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 126: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 127: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 128: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 129: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 130: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 131: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 132: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 133: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 134: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 135: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 136: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 137: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 138: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 139: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 140: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 141: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 142: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 143: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 144: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 145: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 146: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 147: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 148: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 149: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 150: x = 3.8375, y = 8.3156, Costo = 8.3156

Paso 151: x = 3.8375, y = 8.3156, Costo = 8.3156

[Finished in 4.5s]

*****************************************************************************************

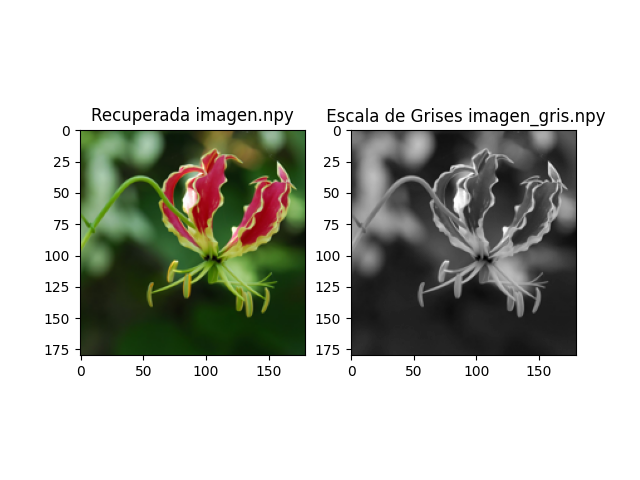

Ejercicio realizado en plataforma Linux, concretamente: Ubuntu 20.04.6 LTS.

Editado en Sublime text.

Ejecución:python3 Aula-28_RMSprop.py

Se deberá tener cargado en el sistema:

import

numpy as np

import

matplotlib.pyplot as plt